ChatGPT非萬能 捏造資訊易中伏 RAG增強生成技術 打破AI「幻覺」

ChatGPT等生成式人工智能(Generative AI)在過去幾個月引起全球熱潮,它們在語言處理及理解方面甚為出色,能在短時間內完成要求,對企業來說應該是很強大的工具。然而,即使AI能解答用戶不少疑問和協助工作,但卻會產生「幻覺」(hallucinations) ,即給予人們貌似合理的錯誤訊息,誤導他人墜入陷阱之中。

上月,美國紐約有律師利用 ChatGPT 翻查案例呈堂,結果被發現其援引案例實由ChatGPT虛構,一度面臨停牌處分,最終被罰款5,000美元(約4萬港元)。其實ChatGPT捏造事實早有先例,它曾錯誤地指責一位美國法律教授的性騷擾行為,並在引用了一份不存在的《華盛頓郵報》報道。另外,Google在今年2月宣傳旗下聊天機器人Bard的影片中,回答對韋伯太空望遠鏡的問題時失誤。

Photo from BusinessFocus

Photo from BusinessFocus

RAG強化答案真實性

生成式AI工具成功展現出各類可能性,不少人只是為了好玩使用,認為即便AI提供「幻覺」也沒有關係。不過要應用於商業層面時,模型生成的答案就必須準確。為對抗AI「幻覺」,有軟件工程師提出以檢索增強生成 (Retrieval Augmented Generation, RAG) 輔助 AI 生成工具。RAG最先由Facebook研發團隊提出,這個模式結合信息檢索和生成模型的優點,使AI能夠更有效地從大量數據中提取和生成信息。

該技術建基於 Natural Language Processing (自然語言處理,NLP),並結合文本檢索 (Text Retrieval)。RAG模式工作原理是,首先從大量的文檔中檢索出與用戶提問相關的內容,然後將這些資訊作為上下文,並生成回答。

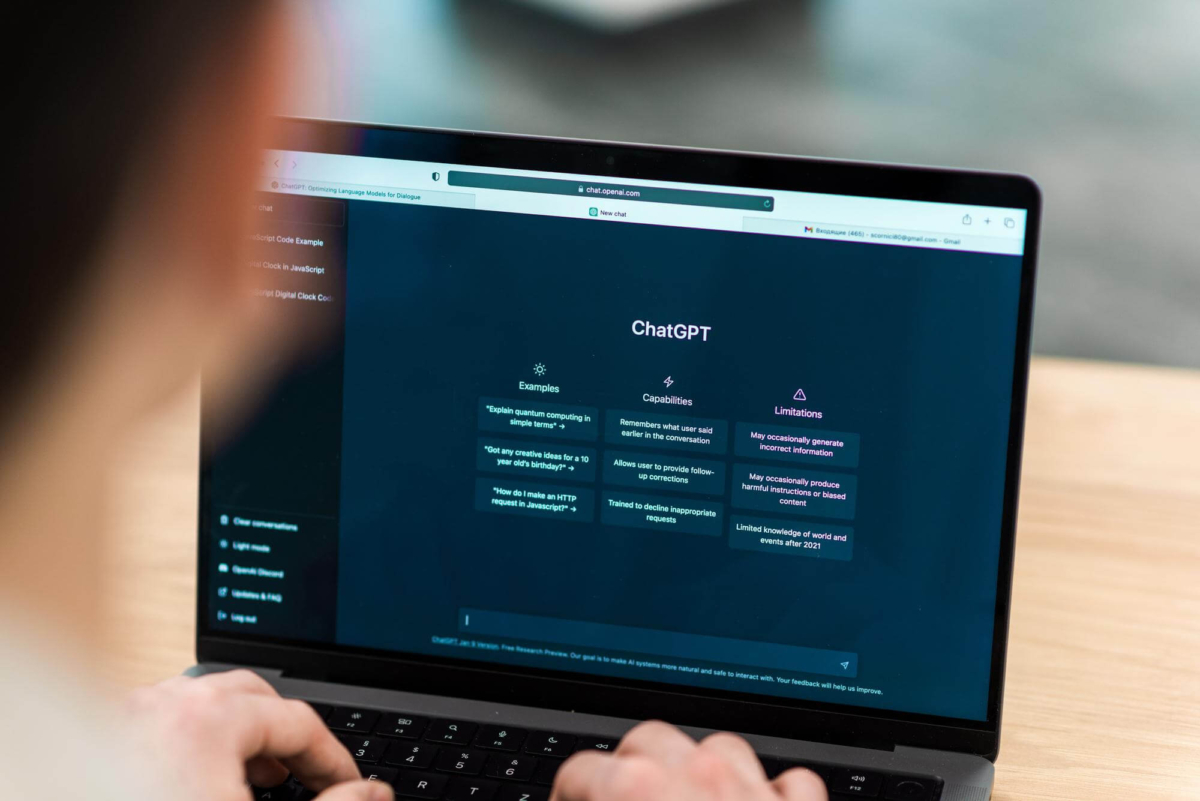

RAG模式的優點是利用大量的真實數據,得出更準確及更具有語境的回答。微軟工程師Pablo Castro今年5月在其網誌舉例指,用戶向支援 RAG技術的問答系統提問保險涵蓋範圍時,模型不但理解保單內容,更可抽取最相關資訊,準確解答疑問。

Photo from BusinessFocus

Photo from BusinessFocus

建構客製化AI對話模型

目前類似ChatGPT的AI模型,一般只能讀取在訓練語言模型時曾學習過的資訊,對個人或企業內部資訊卻一竅不通,無疑限制了生成式AI對企業的實用性。

微軟正進一步以 RAG 技術推動AI開發,另外市場上亦已有相關服務,包括社交商務軟件 SleekFlow 及亞馬遜旗下的 AWS (Amazon Web Services) 。在RAG技術配合下,企業只需透過上傳相關文本或企業現有知識庫作為訓練客服機械人的內容,即可建構客製化AI對話模型,不但能確保答案可靠及準確,同時能協助處理複雜查詢,並提供人性化對答,對於有高度顧客互動需求的行業,如保險、銀行及美容零售等更有助益。

Text by BusinessFocus Editorial