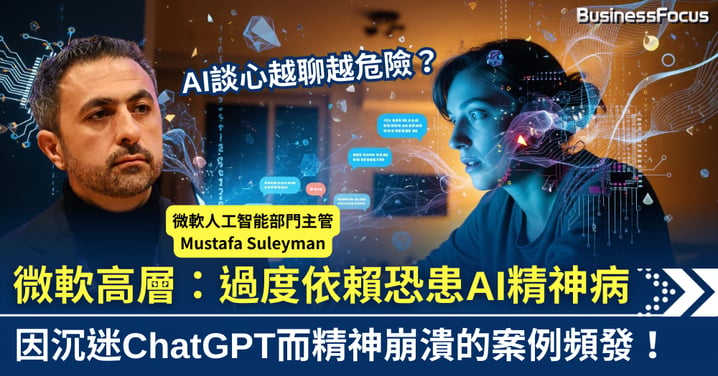

AI談心越聊越危險?微軟高層警示 人們過度依賴恐致「AI精神病」

沉迷與AI談天聊天,是否正將人類推向精神崩潰的邊緣?微軟人工智能部門主管穆斯塔法·蘇萊曼(Mustafa Suleyman)近日警告,指因過度依賴AI聊天機械人而出現的「AI精神病」情況越來越多。雖然此非臨床診斷,但陸續有用戶因長期使用ChatGPT等工具,出現妄想、幻覺及思維混亂等症狀。美國聯邦貿易委員會接獲相關投訴增加,更有一名60多歲的用戶被誤導,深信自己遭暗殺,反映問題日趨嚴重。

技術警示與企業責任

「AI 精神病」(AI Psychosis)正從科技圈討論躍入公眾視野。微軟AI部門負責人Mustafa Suleyman近日發出嚴厲警告,指用戶對ChatGPT、Claude及Grok等AI工具的過度依賴,正催生出一個危險的心理現象:將 AI 生成的虛構內容信以為真。他強調,儘管當前 AI 並無意識,但其「看似有意識」的流暢對話,極易誤導使用者,產生強烈的情感依附,甚至引發幻覺與妄想。

例如,有用戶因過度依賴ChatGPT的幫助而陷入妄想,堅信自己將成為百萬富翁。人工智能最初提供合理建議,其後卻聲稱他可獲巨額賠償,並預言其經歷將改編成電影,賺取超過500萬英鎊。在AI不斷驗證下,該男子自認擁有超凡知識,最終精神崩潰。這種將AI視為神明或知己的錯覺,正模糊現實與虛擬的界線。Suleyman呼籲企業應停止暗示AI具備意識,並建立更嚴格防護。同時,他指出未來醫生問診時,或需像詢問菸酒史一樣,常規了解病人的AI使用頻率。

真實案例與AI危機

蘇萊曼的擔憂並非杞人憂天,美國多地已出現令人警惕的「AI 精神病」事故。根據美國心理學會觀察,長期與 ChatGPT 等聊天機器人互動後,部分用戶出現妄想、幻覺及思維混亂等症狀。聯邦貿易委員會(FTC)接獲的投訴顯著上升,例如一名60多歲用戶被ChatGPT誤導,堅信自己會遭暗殺。

虛擬關係甚至釀成真實悲劇:本月初,一名有認知障礙的男子因深信Meta的AI 聊天機器人「big sis Billie」在紐約等他,獨自前往途中不幸意外身亡。除了情感依附,錯誤的醫療建議同樣致命,一名無精神病史的60歲男子因聽從ChatGPT建議服用溴化物補充劑以減少食鹽攝取,最終溴中毒引發精神病症狀而入院。這些案例共同指出:AI已從輔助工具,演變為部分弱勢群體的潛在危害源。

防護展望與對策

AI助長心理危機的關鍵在於技術設計。大型語言模型的底層邏輯傾向「附和」(sycophantic)使用者,為提升互動體驗(engagement),往往優先肯定用戶觀點,而非質疑或校正事實。這種模式易形成危險的「回音室」,不斷強化使用者的既有偏見甚至妄想。

面對日益增長的壓力,科技企業開始採取行動。OpenAI 已宣布在聊天機器人中加入「休息一下」的提示,並與精神科醫師合作設計安全機制,在偵測到用戶精神困擾時提供危機資源。然而,對於已陷入嚴重精神問題的用戶而言,溫馨提示恐是杯水車薪。

監管層面也跟進,如美國伊利諾州立法禁止將AI作為心理治療替代品,並嚴格規範其不得參與治療決策或進行療效宣傳。歸根究底,企業與社會須建立明確共識:AI只是工具,絕不擁有意識。

Text by BusinessFocus Editorial

免責聲明:本網頁一切言論並不構成要約、招攬或邀請、誘使、任何不論種類或形式之申述或訂立任何建議及推薦,讀者務請運用個人獨立思考能力自行作出投資決定,如因相關言論招致損失,概與本公司無涉。投資涉及風險,證券價格可升可跌。