【AI的抉擇】MIT開發道德模擬器,探討自動汽車該撞死甚麽人

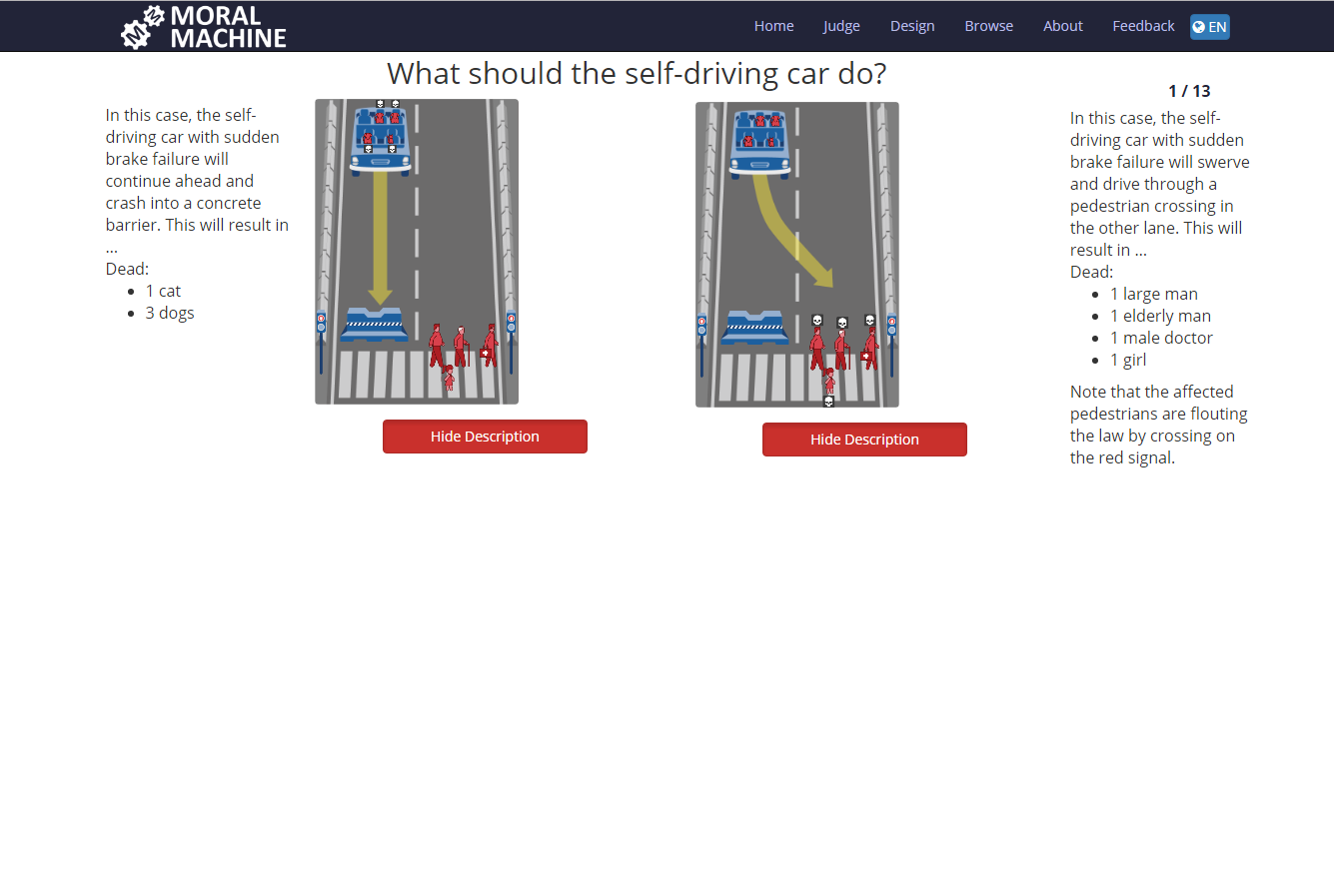

自動駕駛汽車發展越見成熟,但質疑AI的聲音亦日漸響亮。如果遇上一定會造成傷亡的情況,自動駕駛系統會如何選擇?為了探討這個問題,麻省理工學院月前研發了一個模擬器,讓人思考在不同情況下自動汽車應該撞死哪一個人。

Photo from MIT

Photo from MIT

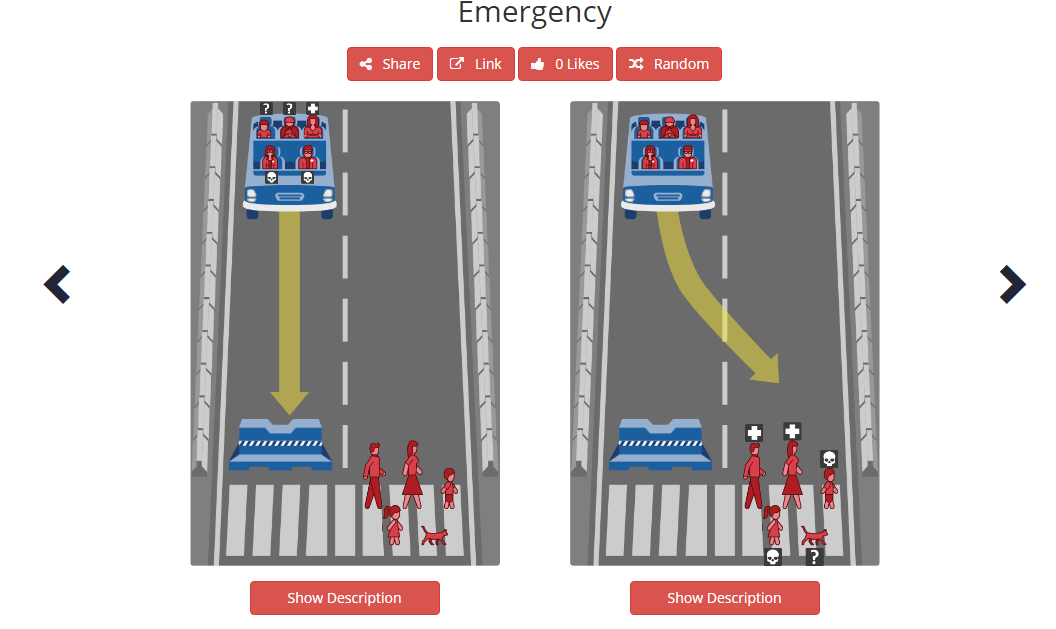

這個名為Moral Machine的模擬器會每次提供不同的選擇題。每一題都會提供兩個一定會造成最少一個人或動物死亡的情況,而模擬器參加者則需要選擇自動汽車應撞死哪些人。

大部分測試題目中都讓人從車輛乘客以及路人的生命中二擇其一:要麽就是路人不幸被自動汽車撞死,要麽就是車上乘客遇上系統故障而不幸身亡。每個情況都設有涉事人士的背景資料,如職業等。

例如,一條模擬題目就讓人選擇讓車上乘客死亡或路人死亡。如果選擇讓車上乘客死亡的話死者將會包括1隻狗和3隻貓;選擇讓路人死亡的話則死者將會包括一名健碩男子、一名年老男子、一名男性醫生以及一名小女孩。這些路人在過馬路時都沒有依照交通燈過馬路的,換言之他們都在衝紅燈。參加者此時就要按照自己的道德原則去選擇讓哪一邊死亡。

Photo from MIT

Photo from MIT

網頁上寫道,Moral Machine是設計成為一個建構「群眾人性意見」的平台以及一個「潛在道德後果情況下的討論」。總的來說,Moral Machine就是用來探討自動機器遇上倫理情況下應該作出什麽樣的選擇。網頁又寫道:「賦予機器更大的自主權能導致一些它們需要自行作出涉及人命的選擇的情況。這模擬器不只是為了探討人類應該作什麽道德選擇,而是更清晰地討論人類應如何理解機械智能去作道德選擇。」